做SEO要处理的第一个问题,就是让搜索引擎收录网站,因为只有页面被收录了才有机会出排名展现。不过在某些情况下,不让搜索引擎收录特定网页,反而是有好处的。下面介绍有什么方法可以限制搜索引擎收录网页。

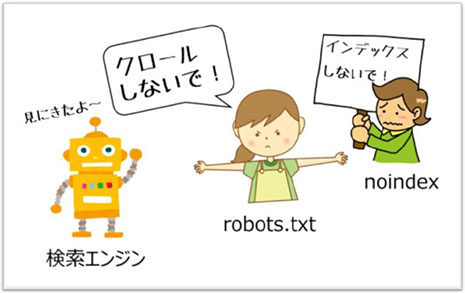

一、收录的基本概念

让我们先简述一下在这篇文章反覆出现的字眼 – 收录,在SEO中到底扮演甚么样的脚色。一般来说,搜索引擎机器人(bot)会根据网页之间的链接进行抓取,在爬完网页后会把有用的资料放进资料库,这个过程称为索引(index)同时也就是本篇的主题 – 收录。

没有被收录,就不可能出现在搜索结果中,更不用谈排名了。对SEO来说,网站能够被正确收录是非常重要的,不过收录并不是单纯的越多越好,如果一个网站收录了很多垃圾内容,反而会让搜索引擎降低对网站的评分,可能会让网站的权重下降。

二、什么样的页面不用被收录

1) 刚上线的网站

在测试或填充内容阶段的网站通常资料是不完整,甚至是不正确的,一般在网站刚上线不久,如果在这个阶段被搜索引擎收录,可能会让搜索引擎误会网站的内容品质不好。对SEO无疑是很大的扣分,建议要避免发生这样的状况。

2) 不能公开的内容

不少网站中存有用户资料、公司的内部资料、后台环境、资料库…等等,如果服务器设定不正确,没有阻挡搜索引擎的爬取与收录,这些内容也是有可能会被收录并直接公开到网络上,过去也确实发生过类似的案例。

3) 不重要页面

这是比较多网站会发生的情况,网站或多或少都会包含一些没有搜索价值的页面,例如:版权声明、法律条款、登入页面、结帐确认页面、用户资料页…等等,当这些页面在收录页面中的比例太高时,有可能会被搜索引擎误会网站的内容空洞,因此伤害到网站权重。

三、禁止网页不被收录的方法

1) noindex 标签

利用“noindex”禁止搜索引擎抓取页面,在不希望被收录的网页<head>中使用以下指令:

<meta name="robots" content="noindex">

利用这个方法可以有效的解决不想要被收录页面。也是比较推荐的方式,可以解决大多数的问题,操作容易,就是需要单页面设定,如果页面数量多会有执行困难,需要后台开发单页面代码插入功能。

2) robots.txt 协议

robots.txt 文件位于网站根目录,能够向搜索引擎爬虫表明你不希望被收录的网站内容路径。在大多数的情况下都可以解决不想被收录的问题,不过 robots.txt 本身还是有一些限制的,比如它不是强制的指令,因此不是每个搜索引擎都会完全遵守 robots.txt 内的协议。

3) 服务器设定解决

直接在服务器上把目录或文件设定成密码存取,例如使用Apache网页服务器时,可以编辑 .htaccess 文件使目录受密码保护。如此一来就可以保证搜索引擎不会抓取,这是最根本且绝对有效的方式,不过这样设定也代表了用户无法查看网页,可能会不符合网站设计的目的,因此这个方法通常只适合应用在敏感的资料上。

总结:当我们利用以上的方式去设定、排除掉一些不需要被收录的页面,对SEO是有一定帮助的,不过在实际操作中,一定要特别注意不要设定错误,如果因为不小心或搞错网页,让原本有排名的页面被移除收录,那么后面还要花时间去让搜索引擎重新收录,还会损失现有流量,所以尽量注意避免这样的情况出现。

还木有评论哦,快来抢沙发吧~